— 【AI时刻】想在手机上本地跑AI?还是让子弹飞一会吧! —

更新时间:2023-11-19 15:50:03 编辑:丁丁小编

热门文章榜

-

- 三星研发QD-OLED面板量子点墨水再生技术 有望降低设备成本和售价

- 三星研发QD-OLED面板量子点墨水再生技术 有望降低设备成本和售价

- 立即抢购

-

- 0.02mm精度+百元天花板,玄派X68磁轴键盘键盘来袭

- 0.02mm精度+百元天花板,玄派X68磁轴键盘键盘来袭

- 立即抢购

-

- 就是“一句话的事儿!” 荣耀先于苹果发布AI Agent

- 就是“一句话的事儿!” 荣耀先于苹果发布AI Agent

- 立即抢购

-

- 华为Watch GT5将采用新传感器技术 有望快速准确监测多项健康数据

- 华为Watch GT5将采用新传感器技术 有望快速准确监测多项健康数据

- 立即抢购

-

- 中国电信9月底升级天通卫星网络 小米OV等通信功能将受影响

- 中国电信9月底升级天通卫星网络 小米OV等通信功能将受影响

- 立即抢购

-

- 铁威马D8 Hybrid硬盘柜:冷热数据存储的完美解决方案

- 铁威马D8 Hybrid硬盘柜:冷热数据存储的完美解决方案

- 立即抢购

热门优惠券

更多-

立即领取

立即领取Office StationeryEarly Black Friday Deal - Free £15 One4All Digital Voucher

Office StationeryEarly Black Friday Deal - Free £15 One4All Digital Voucher -

立即领取

立即领取Office StationeryEarly Black Friday Deal - Free £5 One4All Digital Voucher

Office StationeryEarly Black Friday Deal - Free £5 One4All Digital Voucher -

立即领取

立即领取Paula YoungUp To 80% Off Clearance at Paula Young + Free Shipping On Orders $59+ - Offer Valid 11/8

Paula YoungUp To 80% Off Clearance at Paula Young + Free Shipping On Orders $59+ - Offer Valid 11/8 -

立即领取

立即领取Paula YoungUp To 70% Off Sale at Paula Young + Free Shipping On Orders $59+ - Offer Valid 11/8/24 -

Paula YoungUp To 70% Off Sale at Paula Young + Free Shipping On Orders $59+ - Offer Valid 11/8/24 - -

立即领取

立即领取Spencer'sFree Shipping Over $20

Spencer'sFree Shipping Over $20

最新分享

更多-

立即阅读

立即阅读新AI,新Mate,华为Mate 70系列定档11月26日史上最强大的Mate

2024-11-19 17:10:02 -

立即阅读

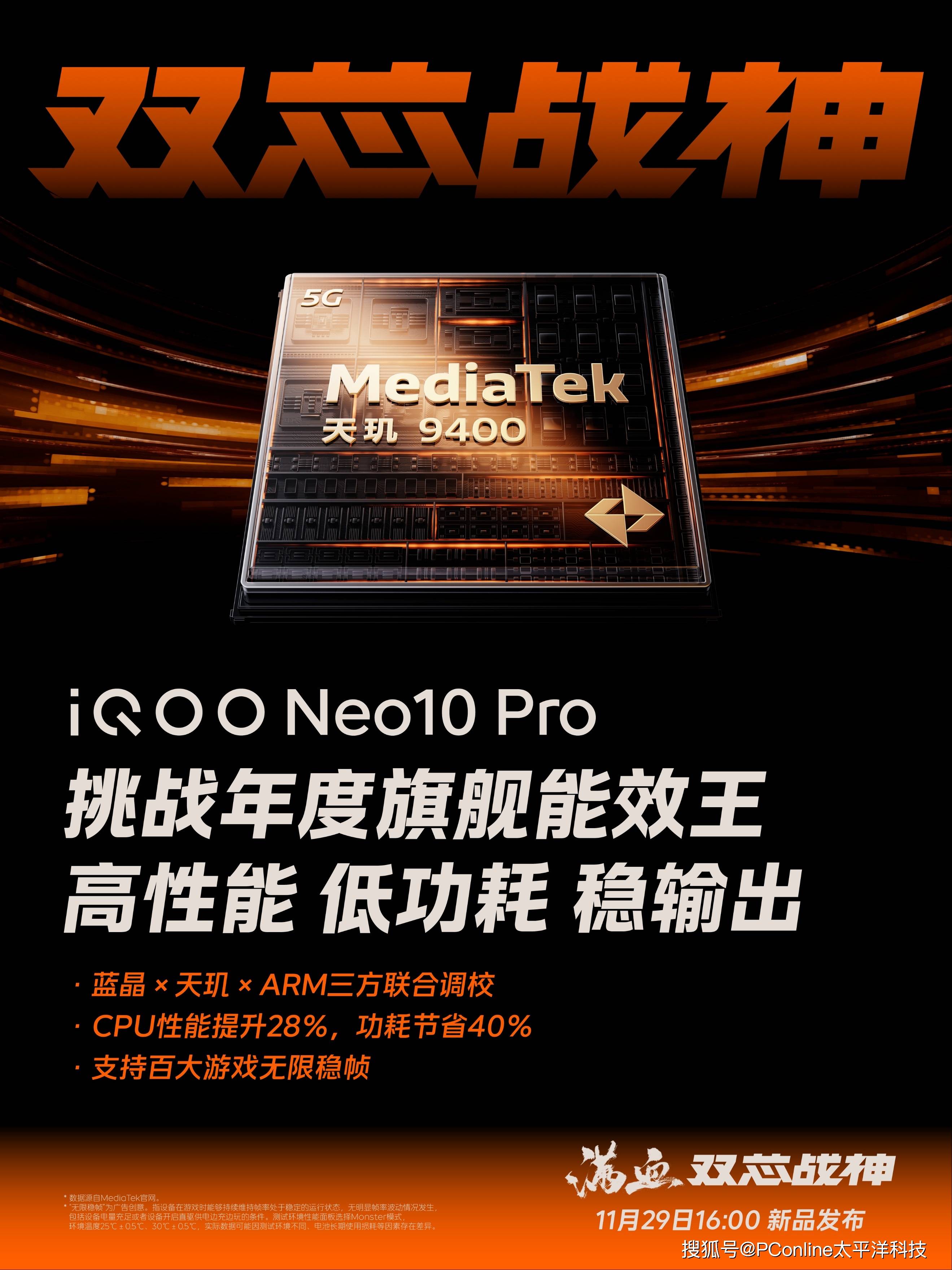

立即阅读双芯重载能效之王?iQOO Neo10 Pro解决重载挑战

2024-11-19 17:05:01 -

立即阅读

立即阅读荣耀首款三折叠屏手机照片曝光 采用Z字形设计和碳纤维材料外壳

2024-11-19 16:05:01 -

立即阅读

立即阅读昆仑万维发布国内首款具备中文逻辑推理能力o1模型——“天工大模型4.0 O1版”邀测即将启动

2024-11-19 15:05:01 -

立即阅读

立即阅读华为WATCH D2腕部动态血压记录仪开启预售 首发2888元

2024-11-19 13:20:04 -

立即阅读

立即阅读华为Mate 70系列样机已到店!现已开启新品预订,预约人数超百万!

2024-11-19 13:15:02 -

立即阅读

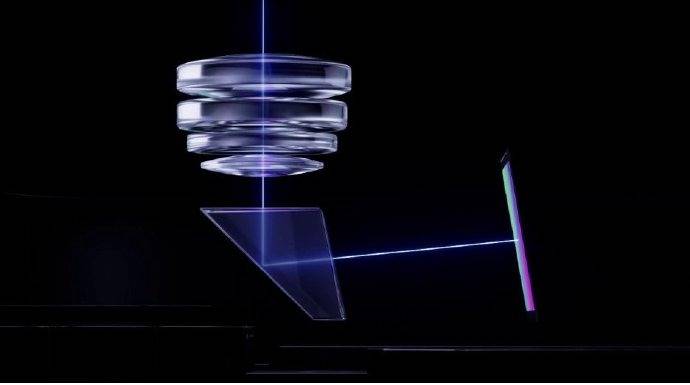

立即阅读三星带来ALoP相机模块设计,潜望长焦有望摆脱“又凸又厚”的传统形态?

2024-11-19 13:10:02 -

立即阅读

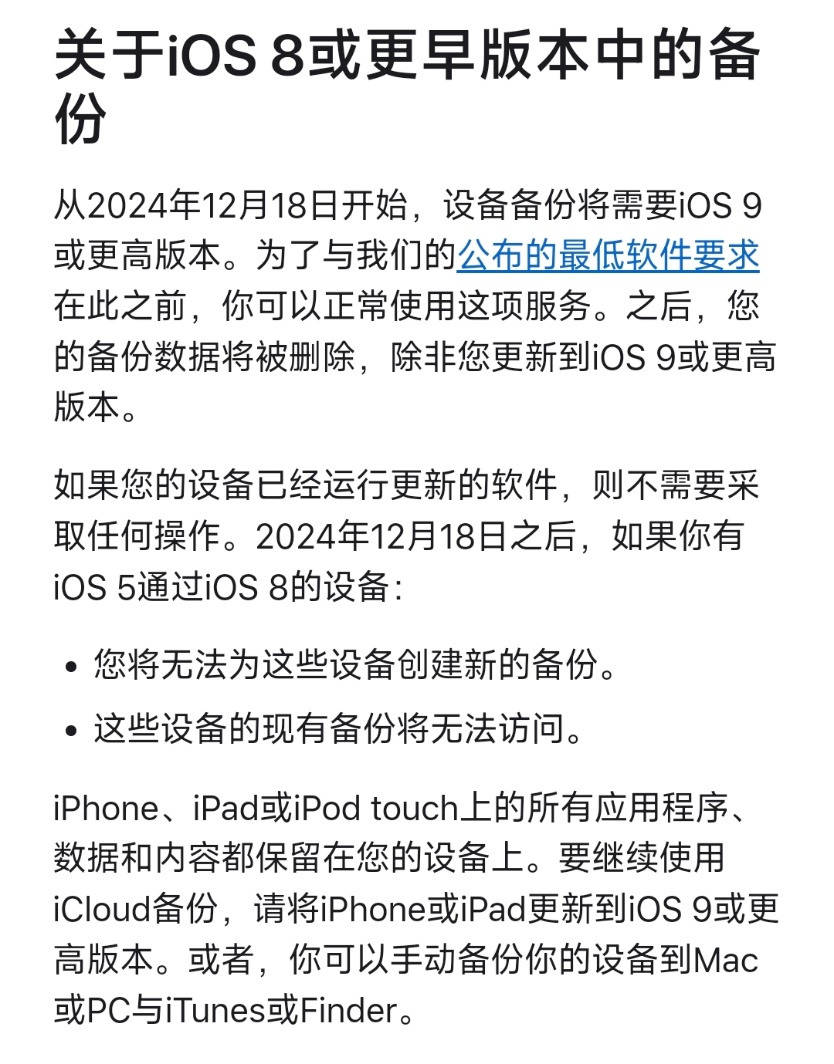

立即阅读苹果将不再为iOS 8及之前版本的iPhone、iPad提供iCloud备份服务

2024-11-19 13:05:02 -

立即阅读

立即阅读科沃斯T50 PRO:扫地机器人界的全能“黑科技”爆款来袭!

2024-11-19 12:20:03 -

立即阅读

立即阅读科沃斯X8 Pro Plus:智能黑科技,重塑生活新净界

2024-11-19 12:15:04