— 【Ai时刻】都知道NVIDIA赚翻了,其实背后赢麻了的还有它! —

更新时间:2023-07-06 09:19:55 编辑:丁丁小编

耕升GT1030/7102G电脑游戏显卡【优惠券:满100元减10元】

Gainward/耕升GT 1030/710 2G家用办公显示网游Nvidia独立显卡领券购买

本文转载于:https://www.sohu.com/a/694880368_223764 如有侵犯,请联系dddazheyh@163.com删除

热门文章榜

-

- 适合学生党的性能长续航手机,就选这三款“卷王”

- 适合学生党的性能长续航手机,就选这三款“卷王”

- 立即抢购

-

- 三星研发QD-OLED面板量子点墨水再生技术 有望降低设备成本和售价

- 三星研发QD-OLED面板量子点墨水再生技术 有望降低设备成本和售价

- 立即抢购

-

- 0.02mm精度+百元天花板,玄派X68磁轴键盘键盘来袭

- 0.02mm精度+百元天花板,玄派X68磁轴键盘键盘来袭

- 立即抢购

-

- 高通骁龙8Gen 4将搭载自研CPU 首发双版本其一或为高性能版

- 高通骁龙8Gen 4将搭载自研CPU 首发双版本其一或为高性能版

- 立即抢购

-

- 就是“一句话的事儿!” 荣耀先于苹果发布AI Agent

- 就是“一句话的事儿!” 荣耀先于苹果发布AI Agent

- 立即抢购

-

- 华为Watch GT5将采用新传感器技术 有望快速准确监测多项健康数据

- 华为Watch GT5将采用新传感器技术 有望快速准确监测多项健康数据

- 立即抢购

热门优惠券

更多-

立即领取

立即领取MAC CosmeticsFree Full-Size Fix Plus Setting Spray with Your $80 Purchase! Code: EXCLUSIVE80

MAC CosmeticsFree Full-Size Fix Plus Setting Spray with Your $80 Purchase! Code: EXCLUSIVE80 -

立即领取

立即领取The Hut UK25% off new season essentials

The Hut UK25% off new season essentials -

立即领取

立即领取AllSole UK25% off selected lines

AllSole UK25% off selected lines -

立即领取

立即领取James Lane30% Off Storewide (Code: BLACK30)!

James Lane30% Off Storewide (Code: BLACK30)! -

立即领取

立即领取Bluebella AUSingle's Day Offer - 15% Off Full Price when You Spend A$95 with Code BB15SINGLESDAY

Bluebella AUSingle's Day Offer - 15% Off Full Price when You Spend A$95 with Code BB15SINGLESDAY

最新分享

更多-

立即阅读

立即阅读Dynabook旗下16英寸笔电TECRA A60-M:商务精英的全能伙伴 大屏释放商务潜能

2024-11-15 18:10:01 -

立即阅读

立即阅读Fit的三重境界,索尼LinkBuds Fit如何演绎?

2024-11-15 18:05:03 -

立即阅读

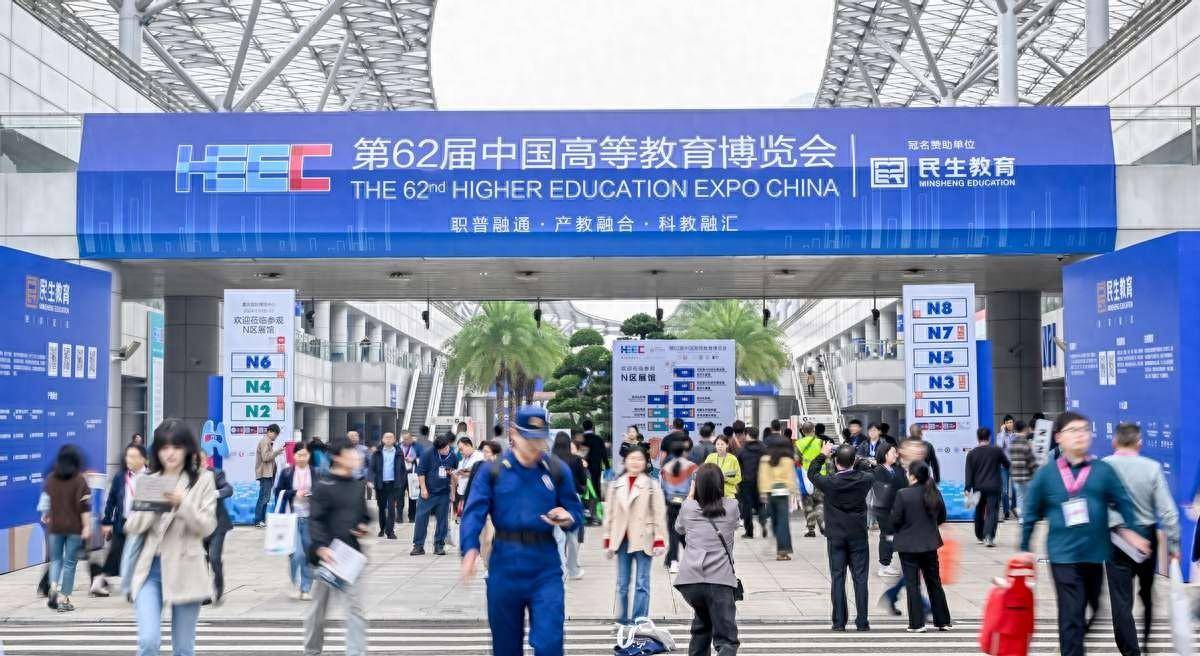

立即阅读从高博会看未来:华为擎云智慧教育解决方案助力新质人才培养

2024-11-15 17:05:02 -

立即阅读

立即阅读宅家玩游戏,没有称手的工具怎么行

2024-11-15 15:05:05 -

立即阅读

立即阅读玩物近话论:小巧轻便随心所往,飞猫智联U9 4G随身wifi助力恒山之行无线畅联

2024-11-15 11:10:03 -

立即阅读

立即阅读小巧轻便随心所往,飞猫智联U9 4G随身wifi助力恒山之行无线畅联

2024-11-15 11:05:04 -

立即阅读

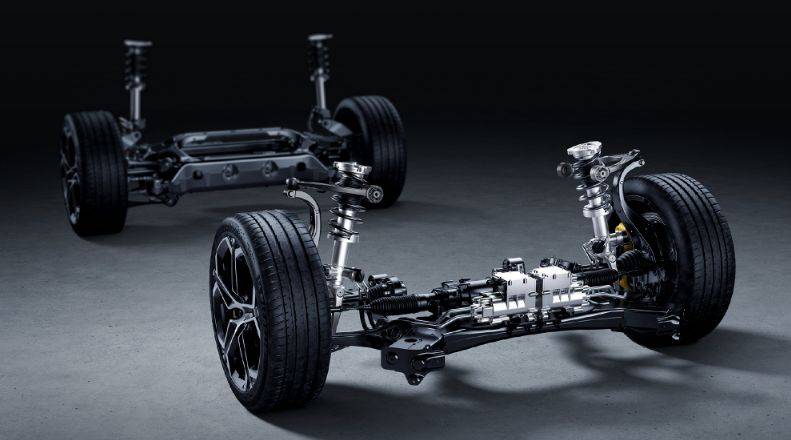

立即阅读雷军称小米智能底盘技术非PPT 现已进入试验车测试阶段

2024-11-15 10:20:03 -

立即阅读

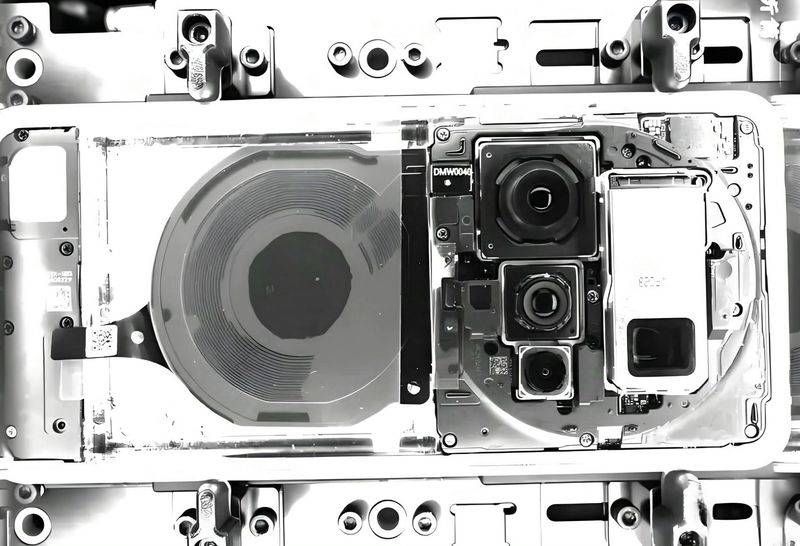

立即阅读小米15 Ultra内部结构图曝光 镜头布局大幅调整

2024-11-15 10:10:02 -

立即阅读

立即阅读小米汽车发布四项智能底盘预研技术 目标原生支持全自动驾驶

2024-11-15 10:05:03 -

立即阅读

立即阅读维信诺推出F1发光材料体系 小米OV等六家厂商将推相应终端设备

2024-11-15 10:00:03